Deepfake sexual, la nueva forma de acosar sexualmente en internet

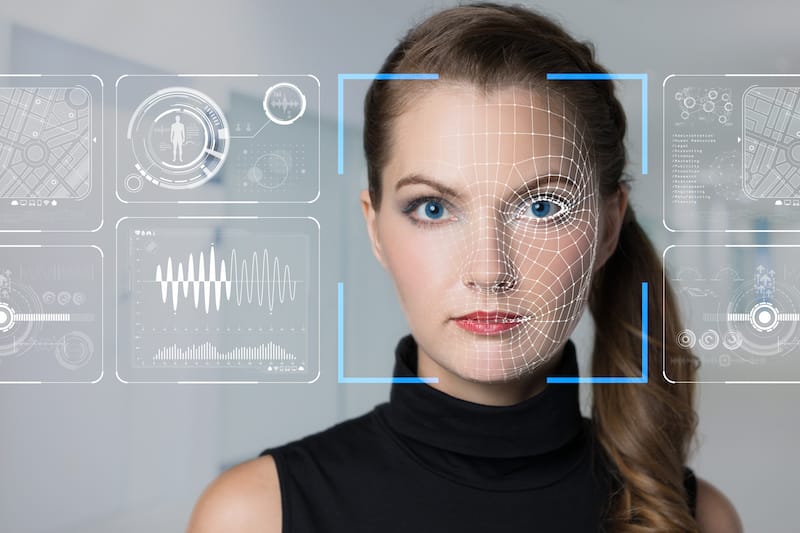

El aumento en la producción de deepfakes, contenido audiovisual manipulado mediante inteligencia artificial, ha registrado un alarmante aumento del 464% en la cantidad de vídeos pornográficos manipulados entre 2022 y 2023, según el informe State of deepfakes 2023 de Home Security.

Desde su surgimiento hace aproximadamente cinco años, este tipo de contenidos maliciosos se ha utilizado de manera constante para acosar a mujeres. Con los avances recientes en tecnologías de IA como el aprendizaje automático, la cantidad de estas piezas que suplantan identidades pululan en la web.

Esto representa un desafío para los motores de búsqueda, que luchan por eliminar estas representaciones falsas y sexualmente explícitas que continúan circulando a pesar de las medidas actuales.

Las mujeres son las principales víctimas

El fenómeno de los deepfakes ha tenido un impacto significativo, con actrices y artistas como Emma Watson, Natalie Portman, Scarlett Johansson y Rosalía denunciando ser víctimas de estas imágenes falsas.

Es importante recordar que esta tecnología, que utiliza inteligencia artificial para generar montajes en video, imagen o audio, afecta principalmente a mujeres y menores de edad, vulnerando su imagen y dignidad personal.

Esto tiene un efecto psicológico profundo, mostrando prácticas sexuales que nunca ocurrieron pero que parecen muy realistas según expertos.

Lo más preocupante es que el 98% de las imágenes falsas que circulan en internet son de naturaleza sexual, según el informe de Home Security, que indica que el 99% del contenido pornográfico falso compromete al género femenino.

Cómo identificar un deepfake

Los deepfakes pueden parecer tan auténticos que identificarlos puede resultar muy difícil, advierte Eduardo Cruz, CEO de Qustodio, especialista en seguridad digital. existen aplicaciones capaces de modificar su contenido de manera que parece tan real, que da lugar al engaño”.

La principal amenaza es la facilidad con la que cualquier persona, especialmente los jóvenes, puede acceder y usar estas herramientas sin necesidad de conocimientos avanzados.

Afortunadamente, ciertos errores sutiles en estos contenidos pueden ayudar a identificar un deepfake. Detalles como el número y la naturalidad de los parpadeos son clave.

Para detectar un deepfake, es crucial observar aspectos físicos como las manos, difíciles de replicar, y detalles como la duración del video, la sincronización del sonido y la coherencia en el discurso.

Las grandes tecnológicas están desarrollando mecanismos basados en IA para detectar estas manipulaciones.

Qué hacer si soy víctima

Ante un hipotético caso de ser víctima de un deepfake, es fundamental no compartir este tipo de contenidos.

Existen canales prioritarios, como el de la Agencia Española de Protección de Datos, para la rápida interrupción de su difusión.

Adicionalmente, existen vías legales, tanto penales como civiles, para denunciar esta clase de actuaciones y buscar reparaciones.

Los expertos también enfatizan en la importancia de la educación en la digitalización y la conciencia sobre los riesgos asociados al uso de la IA en la generación de contenido falso.

Además, la repercusión psicológica y social de una exposición a deepfakes, especialmente cuando involucra a menores, puede ser devastadora. Es por ello, la pedagogía y el apoyo especializado son cruciales para hacer frente a las consecuencias negativas derivadas de esta forma de ciberacoso.